MoE

# Tag:

- Source/KU_ML2

toc test

MoE(Mixture of Experts)

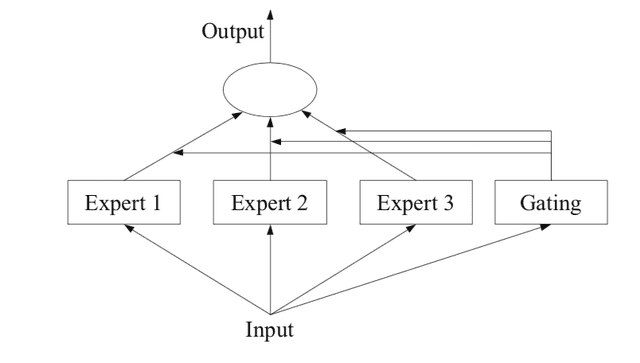

문제를 여러 개의 Experts(전문 models)에게 나누고, 각 experts가 특정 subtask를 처리하도록 설계된 구조이다.

입력 데이터에 따라 각 experts의 가중치를 계산해 각각의 출력치를 가중 합산해 최종 출력을 만든다.

보통 End-to-End 방식으로 학습되며 각 Experts는 자신에게 할당된 데이터(Task)에 대해 최적화 된다.

Gating Network

는 각 experts에 할당되는 가중치이다.

보통 Softmax를 이용해 그 가중치를 만든다.

guassian을 기반으로, 특정 중심 에 대한 Gaussian Distribution function에 대한 Softmax를 만들 수도 있다.

데이터의 분포를 여러 개의 Gaussian Distribution으로 묶어 각각의 experts에게 할당하는 것이다.

Gating Network와 model 모두 Deep Learning으로 처리해 최적의 model까지 찾아내도록 gating Network를 처리하게 하기도 한다.